Recherche Internet : la guerre des Intelligences Artificielles

École de Guerre économique – publié le 3 octbore 2023

https://www.ege.fr/infoguerre/recherche-internet-la-guerre-des-intelligences-artificielles

D’ici 2 ans, il aura été créé plus de données dans le monde que depuis l’origine de l’humanité. Et ceci devrait désormais se répéter toutes les 2 prochaines années environ.

Cette croissance exponentielle de l’information, liée au développement d’Internet et du World Wide Web, ont fait naitre depuis trente ans un besoin stratégique : comment s’orienter dans un univers numérique en explosion ? Comment et où rechercher la bonne information ?

Bien que de premiers pionniers se soient positionnés très tôt sur ce créneau – Altavista, Yahoo, Lycos, etc. – c’est finalement Google qui – à l’aide d’un algorithme ‘PageRank’ révolutionnaire, d’une attention particulière portée à l’expérience utilisateur, et d’un modèle économique basé sur les enchères d’achat de mots clés – s’est imposé à partir des années 2000 comme le leader des moteurs de recherche sur Internet, s’emparant de plus de 90% du marché du « Search », contre environ 3% à son plus proche rival, Bing de Microsoft. Alors que l’on pensait cette position inexpugnable, l’annonce le 30 novembre 2022 de ChatGPT par la start-up OpenAI – puis l’annonce de l’exploitation de cette technologie par Microsoft Bing – a brutalement remis en cause cette position dominante. Cela a conduit le PDG de Google, Sundar Pichai, à mobiliser brusquement l’entreprise autour d’une alerte de type « Code Rouge », et à lancer une contre-offensive informationnelle massive. Une bataille qui s’est jouée avant tout via la communication publique et les médias sur l’échiquier économique d’un marché global du Search de plus de 270 milliards de dollars, mais dont les débordements vers les échiquiers politiques et sociétaux sont en cours. Avec en perspective un impact stratégique : le contrôle de l’accès à l’information sur Internet.

Le contexte de la recherche Internet : une domination écrasante de Google masquant des fragilités sous-jacentes

Quoiqu’il ait subi au fil des années quelques tentatives de concurrence généraliste (avec Microsoft Bing) ou locale (Baidu en Chine, Yandex en Russie, Naver en Corée, Qwant en Europe…) le leadership de Google dans le Search n’avait jamais été remis en cause depuis le début des années 2000. Autour de principes éthiques forts (« Don’t be evil » de 2004 à 2015 puis « Do the right thing ») et d’une stratégie d’excellence technologique, Google avait réussi à se hisser en deux décennies au rang de 4e capitalisation mondiale, élargissant son offre de la recherche Internet vers les services collaboratifs (Google Workspace), les médias (YouTube), le Cloud computing (Google Cloud), la maison connectée (Nest), la santé (Verily, Calico), la voiture autonome (Waymo), etc. Une stratégie de diversification confirmée en 2015 par la transformation de Google en consortium : « Alphabet ».

Mais des fragilités sous-jacentes

Si le chiffre d’affaires (CA) du groupe a atteint le chiffre impressionnant de 280 Milliards de dollars en 2022, les 28% de croissance du groupe par an (depuis son introduction en bourse de 2004) ont longtemps masqué des fragilités sous-jacentes. D’abord une dépendance massive de plus de 80% aux revenus publicitaires, entre Google Search, Google Workspace et Youtube. Ceci contre 9% seulement de CA sur le cloud et moins de 1% sur les autres activités (« other bets »), les deux en perte en 2022. Puis des risques constants d’attaque pour abus de position dominante, matérialisés aux USA en 2022. Et enfin une fragmentation lente mais régulière des usages de la recherche sur Internet (recherche de produits sur Amazon.com, recherches de personnes sur Facebook ou LinkedIn, etc.). Des incertitudes qui ne manquent pas de préoccuper depuis longtemps les investisseurs, qui, tout en plébiscitant Google, valorisent aujourd’hui son action à un prix/bénéfice (forward P/E) inférieur d’un tier (20) à ceux d’autres grands leaders du numérique comme Apple (29) ou Microsoft (30).

C’est dans ce contexte de doute diffus que ChatGPT va faire en novembre 2022 une percée stratégique.

Un coup de tonnerre pour l’image de Google Search : l’annonce de ChatGPT

Le 22 novembre 2022, la société OpenAI lance un agent conversationnel – « chatbot », basé sur l’intelligence artificielle générative – permettant de dialoguer avec les internautes et de répondre à leurs questions : ChatGPT. Fondée initialement en 2015 comme laboratoire de recherche à but non lucratif dédié à développer des systèmes d’Intelligence Artificielle Générale (IAG) sûrs et bénéfiques pour l’humanité, puis renforcée en 2018 par la création d’une filiale commerciale, la société OpenAI n’avait jusque-là pas fait beaucoup parler d’elle hors des cercles spécialisés, si ce n’est à propos de l’implication brève d’Elon Musk, co-fondateur parti en 2018. Avec 1 million d’utilisateurs en 5 jours, le lancement grand public de ChatGPT – développé discrètement depuis 2018 – crée un choc mondial. Il est vrai que la promesse est impressionnante : entrainé sur Internet, avec 175 milliards de paramètres, le chatbot est capable de donner l’illusion des réponses quasi humaines et d’un accès instantané au savoir mondial. Pour les (rares) experts, la technologie sur laquelle il s’appuie n’est pas fondamentalement nouvelle, et il s’agit avant tout d’un beau coup marketing d’OpenAI. Pour le grand public, c’est la révélation. Il suffit de moins de deux mois pour que la barre des 100 millions d’utilisateurs soit franchie, et que le lancement de ChatGPT propulse définitivement l’« Intelligence Artificielle Générative » comme la révolution du 21e siècle, dédiée à avoir selon les analystes « un impact similaire à celui qu’ont eu en leur temps l’invention de la machine à vapeur, de l’électricité, et de l’Internet »

Un impact très négatif pour Google

Si l’usage possible de chatGPT est plus large que celui d’un moteur de recherche (dialogue conversationnel, traduction, résumé de textes, création de code informatique, etc.), la concurrence possible avec Google Search fait rapidement la Une. Qu’attendent effectivement les internautes d’un moteur de recherche ? Ce que propose Google : une liste de liens correspondant à des mots clés ? Ou une réponse précise ? Ces interrogations lancinantes vont rapidement créer un buzz négatif : « ChatGPT va-t-il remplacer Google ? » Est-ce comme le disent certains le « moment iPhone » de la recherche Internet ? Google est-il un « mort en sursis », tout comme les premiers leaders du téléphone mobile – Nokia et BlackBerry – ont été tués par Apple ? Beaucoup d’utilisateurs le proclament sur les réseaux sociaux : “Google is done“, “OpenAI just killed Google”, etc. Les tests de comparaison entre ChatGPT et Google fleurissent et sont répercutés sur des sites de presse majeurs.

La presse se fait l’écho d’une « alerte rouge » interne chez Google

Ces interrogations ne pas qu’externes : elles sont aussi et surtout interne à Google. Trois semaines après le lancement de ChatGPT, le New York Times révèle que l’onde de choc a donné lieu à une alerte rouge chez Google. Il apparaît même rapidement que les deux fondateurs de Google, Larry Page et Sergey Brin, qui s’étaient éloigné de la maison mère pour se consacrer aux activités émergentes d’Alphabet ont été rappelés à la rescousse et multiplient les réunions d’urgence.

L’occasion rêvée pour Microsoft de déstabiliser son rival de toujours

C’est à ce moment où Google est affaibli que son principal concurrent dans la recherche Internet, Microsoft Bing, lance une attaque frontale. Le potentiel de ChatGPT n’a pas échappé à Microsoft, qui est un investisseur majeur d’OpenAI depuis 2018. Avec Bing, Microsoft essaye depuis longtemps de concurrencer Google Search, mais sans succès notable jusque-là. Il voit avec la percée de ChatGTP l’occasion de bouleverser enfin les positions établies et va faire une succession d’offensives médiatiques auprès des utilisateurs, des annonceurs, des influenceurs, et des investisseurs.

10 millions de dollars investis dans OpenAI et une intégration à Bing

Le 23 janvier 2023 Microsoft lance l’offensive en annonçant investir 10 milliards de dollars dans OpenAI. Le 7 février, Microsoft annonce l’intégration des technologies d’OpenAI dans ses offres Edge, Microsoft 365, etc. Et elles seront aussi et surtout intégrées à Bing ! Un lancement de « Bing AI » qui sera immédiatement effectif (en préversion sur liste d’attente), avec une adaptation spécifique de la technologie d’OpenAI au Search, et la promesse de « réinventer le futur du Search ». « C’est un nouveau jour pour la recherche Internet » déclare le PDG de Microsoft, Satya Nadella. Au contraire de ChatGPT, le nouveau Bing disposera des dernières informations sur Internet (alors que Chat GPT 3.5 était bâtit sur un corpus de données Internet ne dépassant pas 2021). De plus, il citera ses sources.

Bing AI : vers un nouveau paradigme pour la recherche Internet ?

L’annonce de Microsoft est forte : elle prétend bouleverser le paradigme du Search. Va t’elle détrôner Google ? Elle semble avoir un retentissement sensible. Un mois plus tard, dès le 8 mars, Microsoft rapporte que la préversion de Bing AI aurait gagné un million d’utilisateurs et que Bing a atteint 100 millions d’utilisateurs actifs par jour. Signe selon Microsoft d’une nouvelle tendance de fond dans un marché de la recherche Internet assez stable jusque-là… Le 4 mai, Bing AI est enfin disponible à tous, sans liste d’attente, et devient multimédia. Suit une liste continue d’améliorations progressives au cours des mois.

La contre-attaque informationnelle de Google en 4 phases

Si Google travaille depuis longtemps sur l’intelligence artificielle, l’offensive semble le surprendre. C’est d’autant plus paradoxal que le PDG de Google, Sundar Pichai, l’a positionné dès 2016 comme une « AI-first company », dédiée à utiliser l’IA dans tous ses services, et que c’est justement Google Brain, un des deux laboratoires d’IA de Google, qui a été à l’origine des technologies de « Transformers » et de « Large Langage Model » (LLM) dont OpenAI s’est inspiré. Des expérimentations pionnière qu’il hésitait à sortir des cartons, du fait de craintes sur la qualité des résultats et de précédentes polémiques[i]. Ceci combiné à la volonté évidente d’avancer prudemment pour ne pas cannibaliser son modèle économique publicitaire. L’aversion au risque et le dilemme classique du leader ! La valorisation d’Alphabet s’érodant de mois en mois depuis le pic de mi 2021 (-40%) et la pression concurrentielle et réputationnelle s’intensifiant, Google est au pied du mur : il se doit de réagir. Il le fait en 4 phases.

Phase 1 – Lancer une mobilisation des équipes, pilotée par le PDG d’Alphabet lui-même Sundar Pichai, et dont on laisse la presse se faire l’écho

Il faut non seulement remobiliser l’interne. Il faut le faire savoir en externe pour rassurer les investisseurs et les annonceurs. De décembre 2022 à janvier 2023, Google se prépare à la bataille. Il se doute qu’en plus de la menace d’OpenAI, il va être directement attaqué par Microsoft – investisseur d’OpenAI – sur le Search. La communication à la presse est souterraine mais ferme : la réponse de Google va venir bientôt. “Nous continuons de tester nos technologies d’IA en interne pour nous assurer qu’elles soient pleinement efficaces et sûres, et nous sommes impatients de partager bientôt ces expériences en externe” souligne mi-janvier Lily Lin, une porte-parole de Google, au New York Times qui a rapporté l’alerte rouge chez Google. En parallèle, Google gagne du temps en s’assurant que des extensions ChatGPT soient disponibles sur son navigateur Chrome. Un moyen de garder les utilisateurs chez Google.

Phase 2 : contribuer souterrainement à laisser le battage médiatique sur ChatGPT se calmer et le marché souligner ses faiblesses

Comme les analystes le soulignent dans leur classique « cycle du hype » : après le « pic des attentes exagérée » vient vite « l’abîme de la désillusion ». Il est vite clair que, si les capacités de ChatGPT ont d’abord bluffé beaucoup d’utilisateurs, une utilisation régulière vient rapidement les relativiser. Biais, erreurs (poétiquement nommées « hallucinations »), incapacité à discerner information, rumeurs et désinformation, non réplicabilité… : les résultats de ChatGPT sont parfois éblouissants mais souvent aussi immatures. Au point que le PDG d’OpenAI, Sam Altman lui-même, doit rapidement reconnaître qu’il est « prématuré de se fier à ChatGPT pour quoi que ce soit d’important ». Google en est bien conscient. C’est un défaut de tous les LLM. C’est bien pour cela qu’il n’avait jusque-là pas lancé le sien auprès du grand public. OpenAI et Microsoft, tout à leur offensive marketing, se gardaient bien de mentionner ces faiblesses. Google laisse la presse s’en saisir et les experts le souligner. Cela contribue à faire émerger progressivement un relatif consensus médiatique : les chatbots conversationnels sont encore expérimentaux. Ils ne remplaceront pas le « Search » mais le compléteront. Ils sont utiles pour répondre à certaines questions, pour peu que l’on ait conscience de leurs limites. Google Search est de son côté particulièrement efficace pour trouver à peu près tout sur Internet. Bref, le futur est à la conjonction des deux. C’est là où Google va se positionner dans les deux phases suivantes de la contre-attaque.

Phase 3 : Réaffirmer publiquement le leadership de Google en IA, et sa capacité à combiner le plus efficacement « Search » et IA générative

Dès janvier, et alors que la valorisation d’Alphabet est au plus bas depuis son pic de mi 2021 (-40%), Google est prêt pour réaffirmer son avance technologique dans le domaine de l’intelligence artificielle, via une approche médiatique tous azimuts (relations presse, blogs institutionnel…). Mi-Janvier, une série de publications sur son blog viennent rappeler à la presse et au grand public la mission de Google sur l’IA, comment il applique l’IA pour répondre aux enjeux sociétaux, la manière dont il applique l’IA dans ses produits, etc. Cette approche est également particulièrement active auprès des investisseurs, à l’occasion des conférences dédiées aux analystes financiers, comme le 2 février 2023 (Q4 earning call) où le PDG de Google Sundar Pichai focalise l’essentiel de son intervention introductive sur les réalisations de Google en IA et l’imminence d’annonces majeures à ce sujet.

Phase 4 : contre-attaquer via l’annonce portée par le CEO lui-même du propre agent conversationnel de Google : Bard

Le 6 février, c’est le PDG de Google lui-même, Sundar Pichai, qui court circuite l’annonce de Satya Nadella, PDG de Microsoft, prévue le lendemain, pour annoncer que Google lancera son propre chatbot, Bard. Celui-ci est positionné comme un « service d’IA collaboratif » plutôt que comme un moteur de recherche, et sera disponible le 21 mars, tout comme une API ouverte aux développeurs. Il rappelle par ailleurs que c’est Google qui est à l‘origine de la technologie de Transformers et de LLM sur laquelle l’IA générative est basée, et que Google travaille à intégrer ces technologies dans tous ses services, de manière fluide et sûre. Une petite pique à OpenAI, à ses hallucinations, et aux risques règlementaires… Ce sera d’ailleurs une constante de Google : insister sur son approche responsable de l’IA, un discours développé depuis 2018.

Fortement attendu, l’annonce de Bard s’avère pourtant chaotique. Dans une copie d’écran de démonstration, partagée par Google, des spécialistes relèvent une petite erreur factuelle dans une réponse de Bard relative au télescope spatial James-Webb. La sanction est immédiate : l’erreur fait le buzz, des médias comme Forbes se demandent comment Google a pu passer du « AI-first au AI-last », les investisseurs doutent, et Google perd 100 milliards de dollars de capitalisation.

Mais Google a jeté les dés. Malgré ces aléas, la contre-attaque finit par porter lentement ses fruits. Le 21 mars, Bard est accessible sur liste d’attente aux USA et en UK. Les premiers retours des internautes sur Bard sont relativement positifs. D’autant plus que Google ne fait pas l’erreur de « survendre » son chatbot. Bard est présenté comme une « expérimentation », et encourage les internautes à signaler toute erreur afin de l’améliorer.

Au cours des mois suivants, il multiplie les annonces insistant sur l’intégration étroite de l’IA et du Search, afin de rendre l’expérience plus fluide et personnalisée pour les utilisateurs, et plus rentable pour les annonceurs. Le 10 mai, Bard est disponible dans 180 pays, sans liste d’attente, et la recherche Internet s’enrichit d’une « Search Generative Experience ».

Progressivement, la situation se stabilise. Bard parvient à s’affirmer dans le paysage et la capitalisation d’Alphabet, après quelques secousses, remonte. Les mois suivants verront la poursuite du renforcement des synergies entre Bard et Search, le lancement d’un nouveau modèle innovant de LLM, PaLM 2, et de multiples initiatives de Google pour assurer la sécurité de l’IA et la rendre responsable, y compris une initiative conjointe avec d’autres acteurs – dont OpenAI – le Frontier Model Forum.

L’analyse du rapport de force 9 mois après le lancement de ChatGPT

Dix mois après le lancement de ChatGPT, sept mois après celui de Bing AI et de Bard, ou en est la situation ?

Un front stabilisé

En termes de parts de marché, le front semblé stabilisé : Google a regagné le terrain perdu. L’offensive de Microsoft n’a pas réussi à faire bouger significativement les lignes. Entre novembre 2022 et août 2023, malgré un léger frémissement pour Bing, les parts de marché sont quasiment revenues à la situation antérieure.

L’image de Google a néanmoins été fragilisée

Bien que Bard, après des débuts chaotiques, se soit installé dans le paysage, que l’image d’OpenAI ait commencé à pâlir (certains articles parlent même de risques de faillite), et que Bing n’ait pas réussi à transformer significativement l’essai, des doutes diffus sur l’avenir de Google subsistant néanmoins chez les utilisateurs, les annonceurs, les influenceurs et les investisseurs. Pour certains partenaires, l’option d’envisager une alliance avec Bing ne serait plus tabou. Le cas Samsung aurait notamment créé la panique chez Google, selon le New York Time. Le coût de la bataille, enfin, est élevé pour Google. Une recherche par LLM coûte 10 fois plus cher en infrastructure et énergie qu’une recherche classique. Microsoft, avec sa part de marché de 33% dans le cloud et ses services Office365, a plus de moyen de rentabiliser cette infrastructure que Google, numéro 3 seulement du cloud avec 9% de part de marché, et challenger du collaboratif avec Workspace.

Le cours de bourse de Google, rétabli après les doutes, est revenu à une situation proche de son pic de mi 2021, mais reste donc à la traine derrière celui de Microsoft, dont le forward P/E est supérieur d’un tier.

Cela va augmenter la pression des investisseurs pour rendre profitable ou rationaliser les autres activités de Google (« other bets »), dont le résultat est pour l’instant négatif. Le licenciement préemptif de 12.000 employés dès mi janvier 2023 doit bien sûr aux craintes de récession partagées par la plupart des acteurs de la tech, mais prend une résonance particulière chez Google : les coûts doivent être optimisés en prévision de batailles difficiles à l’avenir.

De nouveaux entrants en embuscade

Enfin, la bataille a revigoré les concurrents, pour lesquels la possibilité de déstabiliser Google ne parait plus si utopique. Outre Bing, les startups qui s’essayent à la concurrence comme you.com redoublent d’efforts. Sans compter les poids lourds en embuscade, comme Amazon, Meta, Apple voire x.AI (nouvelle société d’Elon Musk, créée en Juillet 2023 avec l’ambition de « comprendre la vraie nature de l’univers », en lien avec Twitter/X et Tesla) qui pourraient s’appuyer sur la puissance de l’IA pour accélérer la transformation des usages. Ceci en profitant notamment de leurs énormes audiences et de leur présence croissante dans les objets connectés (mobile, domotique, casques de réalité virtuelle ou augmentée, voiture connectée …). Des rumeurs prêtent même à Apple le projet de se positionner frontalement face à Google dans le Search, au travers de l’iPhone – qui touche près de 1,5 milliards d’utilisateurs actifs… Comme le soulignent des analystes : il ne s’agit plus seulement de rechercher des informations sur Internet. Le champ de bataille est la façon dont nous interagissons avec tous les appareils intelligents de notre quotidien. Google l’a bien compris. Avec Android, il se positionne dans le mobile et l’Internet des Objets depuis longtemps. Mais ses grands concurrents ont aussi de sérieux atouts dans leur manche.

Le « moment iPhone » ?

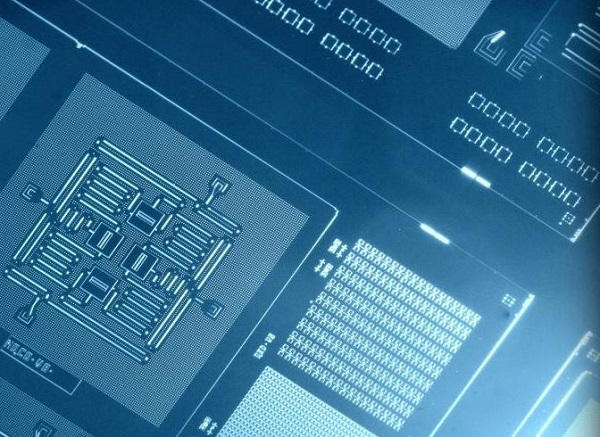

Par ailleurs, comme le souligne avec angoisse une note interne de Google ayant fuité sur Internet, « nous n’avons plus de protection face à la concurrence », l’IA bouleverse non seulement les cartes du Search, mais elle est désormais à la portée d’acteurs de toutes tailles, et remet en cause toutes les positions acquises, y compris d’ailleurs aussi celle d’OpenAI. Il y a une course à la puissance, que seuls les géants peuvent s’offrir du fait du coût des infrastructures de calcul (processeurs Nvidia, etc.). Mais il y a aussi une course à l’innovation agile. Compte tenu des progrès exponentiels de l’IA, et en s’appuyant sur le cloud et les LLM en open source, des startups peuvent désormais faire pour 100 dollars et en quelques semaines, ce à quoi des acteurs établis comme Google ou OpenAI devaient auparavant consacrer des mois et 10 millions de dollars. Ces remarques angoissées font un écho troublant à celles du célèbre mémo de 2011 de l’ancien PDG de Nokia à propos de l’iPhone, mais aussi et surtout à propos d’Android et des concurrents chinois. Le « moment iPhone » est peut-être bien là. Et il dépasse largement le cadre de la concurrence entre Google Search et Bing…

Google génère le doute

Si la première manche de cette guerre informationnelle n’a pas bouleversé les positions concurrentielles faciales, elle donc a créé le germe du doute sur Google chez le grand public, les annonceurs, les partenaires, les influenceurs et les investisseurs. Elle relance la pression des concurrents pour bouleverser la position établie de Google dans le Search, et plus largement dans l’IA.

Cette bataille est d’autant plus cruciale pour Google qu’elle est existentielle : via le Search, elle impacte potentiellement plus de 50% de son chiffre d’affaires [ii].

Inversement, les risques sont proportionnellement bien plus faibles pour les concurrents, notamment Microsoft, pour lequel l’IA est un moteur stratégique qui va souvenir fortement tout le reste de ses activités – Office365, services cloud, etc. – et pour lequel la recherche Internet est avec Bing une activité accessoire[iii].

Dans cette bataille, Microsoft apparait clairement gagnant dans la première manche.

Cette guerre illustre l’asymétrie des risques entre leader et challenger. Innovateur majeur, « disrupteur » de ses prédécesseurs dans les années 2000, Google se trouve aujourd’hui dans une position défensive, sur une technologie d’IA (les LLM) qu’il a pourtant créée et dont il aurait dû être le premier bénéficiaire. Elle illustre aussi l’avantage de l’offensive. En jouant défensif à chaque étape (continuité de l’expérience utilisateur, IA responsable, sécurité…), Google a peiné à convaincre pleinement. Il a surtout été aidé par l’inertie des usages. Beaucoup d’utilisateurs ont néanmoins entraperçu de nouveaux horizons. Même si OpenAI et Bing n’ont pas encore massivement convaincu, ils ont effrité les défenses de Google. De nouveaux chocs – peut-être d’acteurs tiers – pourraient les ébranler plus massivement

Quel sera l’avenir de cette confrontation ?

Il est encore difficile à prévoir. La technologie de LLM est encore jeune. Les usages sont encore émergents. Les nouveaux acteurs prolifèrent. En outre, la bataille va très vite s’étendre de l’échiquier économique aux échiquiers sociétaux et politiques. Les débats sur la propriété intellectuelles, comme les exigences en termes de conformité et de responsabilité se multiplient. Les risques sociétaux de l’IA sur l’emploi, et plus largement, l’humanité, inquiètent. Le 22 mars 2023, 1000 scientifiques dont Elon Musk signaient une lettre ouverte alertant sur ces multiples dangers et appelant à une pause. En Europe et aux USA, les politiques s’apprêtent à légiférer. En Chine, ils le font déjà.

Google sera au cœur de ces batailles. Son principal concurrent, Microsoft, a su se réinventer face à des crises existentielles similaires (Internet dans les années 90, l’open source dans les années 2000, le cloud dans les années 2010). Google aura-t-il cette capacité, alors qu’il n’avait pas rencontré de rival sérieux sur son cœur de métier depuis des décennies ? Pour Google plus que pour tout autre acteur et compte tenu de sa mission affichée d’ « organiser les informations à l’échelle mondiale pour les rendre accessibles et utiles à tous », cette guerre sera totalement informationnelle. Comme le souligne Sundar Pichai le 5 septembre 2023, à l’aube des 25 ans de Google : qu’à fait Google jusque-là sinon d’aider le monde à trouver des réponses à ses questions du quotidien ? Pour les 25 prochaines années, d’ici 2048, l’enjeu sera de répondre aux questions de l’avenir et de chercher de nouvelles frontières. Google a des atouts dans cette bataille. Mais, tout en restant prudent, il devra désormais être offensif.

Jean-Christophe Spilmont (MSIE42 de l’EGE)

Notes

[i] En 2017, c’est Google qui a publié le premier article « Attention is All You Need », sur la technologie « Transformer », à l’origine de l’AI générative, puis qui a créé le premier « Large langage Model » (LLM), BERT. Les recherches de Google en matière d’innovation et d’IA ont néanmoins été marquées à plusieurs reprises par des polémiques, notamment mi 2022 sur son modèle LaMDA, qu’un ingénieur de Google avait clamé auprès de la presse être conscient, allant jusqu’à chercher des conseils juridiques pour « protéger » LaMDA de Google! Une polémique qui s’était soldée par le renvoi de l’ingénieur, et avait incité la direction de Google à ne pas lancer publiquement le chatbot. 5 mois après, OpenAI, sans s’embarrasser de telles précaution, lançait ChatGPT… Le dilemme classique de l’innovateur : un challenger comme OpenAI – ou Microsoft Bing – peut prendre plus de risques qu’un leader établi comme Google Search. Au pied du mur, c’est en s’appuyant sur le modèle LaMDA que Google lancera finalement Bard début 2023

[ii] Le revenu du « search » est comptabilisé dans « Google Search & others » et qui a représenté plus de 162 milliards de Dollars de revenus en 2022, sur un chiffre d’affaires global de 282 milliards.

[iii] Le revenu du search est estimé chez Microsoft à moins de 12 milliards de Dollars en 2022, sur un chiffre d’affaires global de 198 milliards de dollars